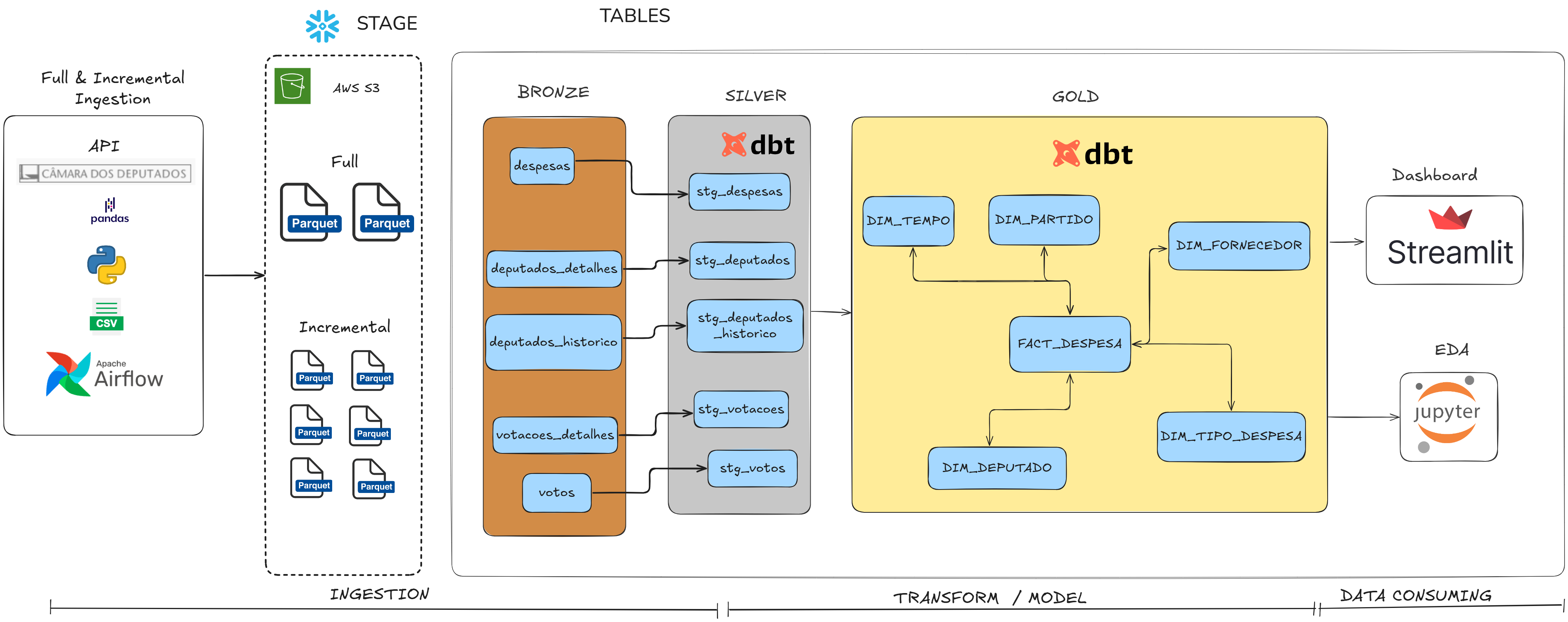

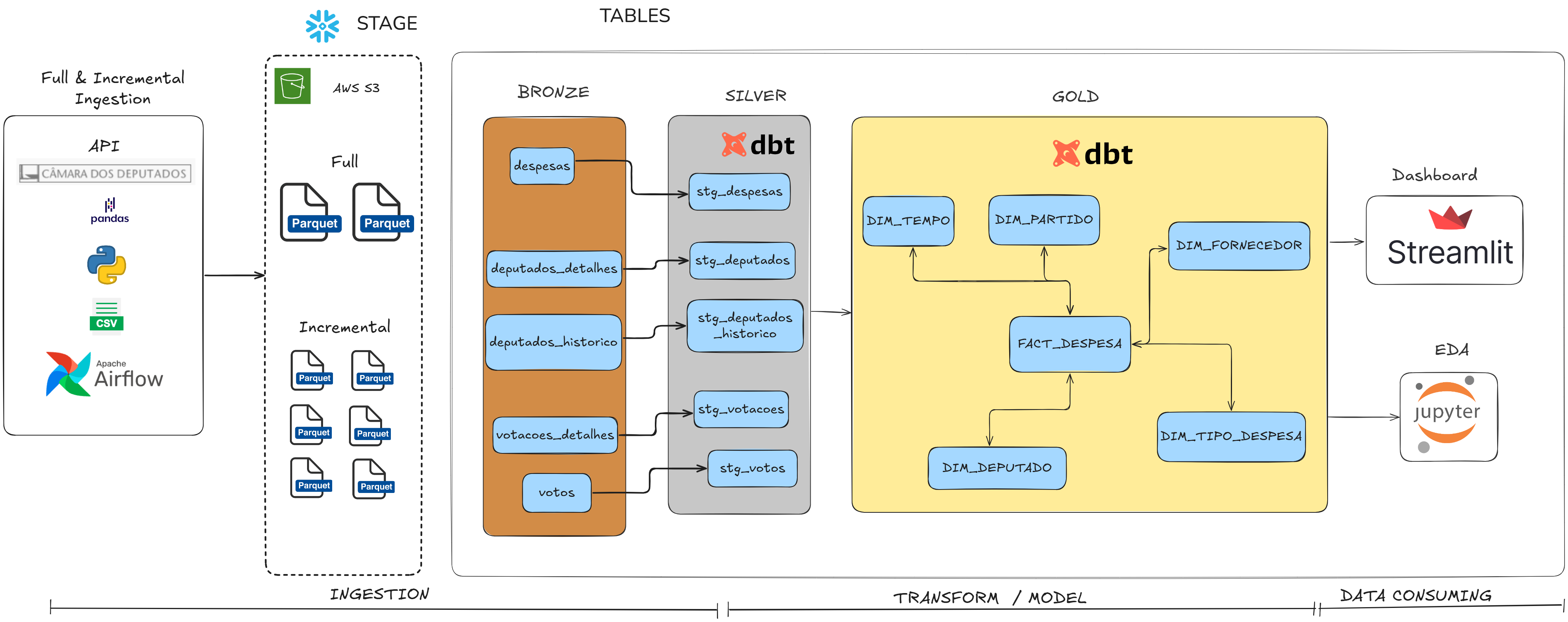

Pipeline de Dados da Câmara dos Deputados

Pipeline de dados completo voltado para engenharia de dados, com ingestão automatizada de informações públicas de todos os deputados federais.

Os dados incluem biografia, mandatos, despesas e atividade parlamentar, extraídos via API oficial.

A arquitetura implementa uma abordagem moderna de ELT com Snowflake e dbt.

A ingestão incremental diária é orquestrada com Airflow e armazenada no S3 em formato Parquet.

Transformações seguem padrões robustos de modelagem dimensional (SCD Type 2).

O projeto garante escalabilidade, automação e qualidade de dados ponta a ponta.

Ferramentas utilizadas

- Python, Pandas e requests

- Apache Airflow

- Amazon S3 e SQS

- Snowflake, Snowpipe

- dbt Core

- Streamlit e Jupyter notebook

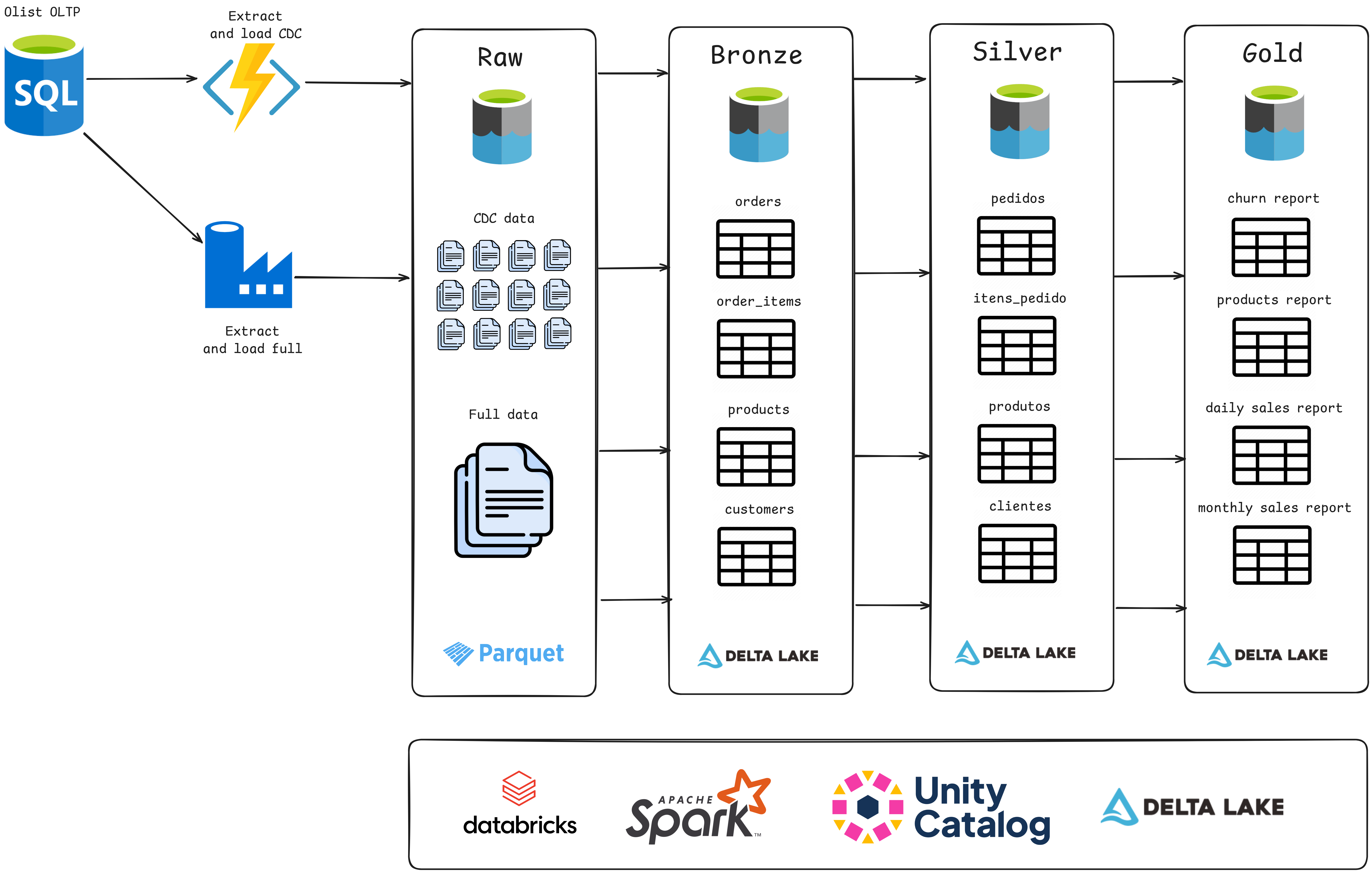

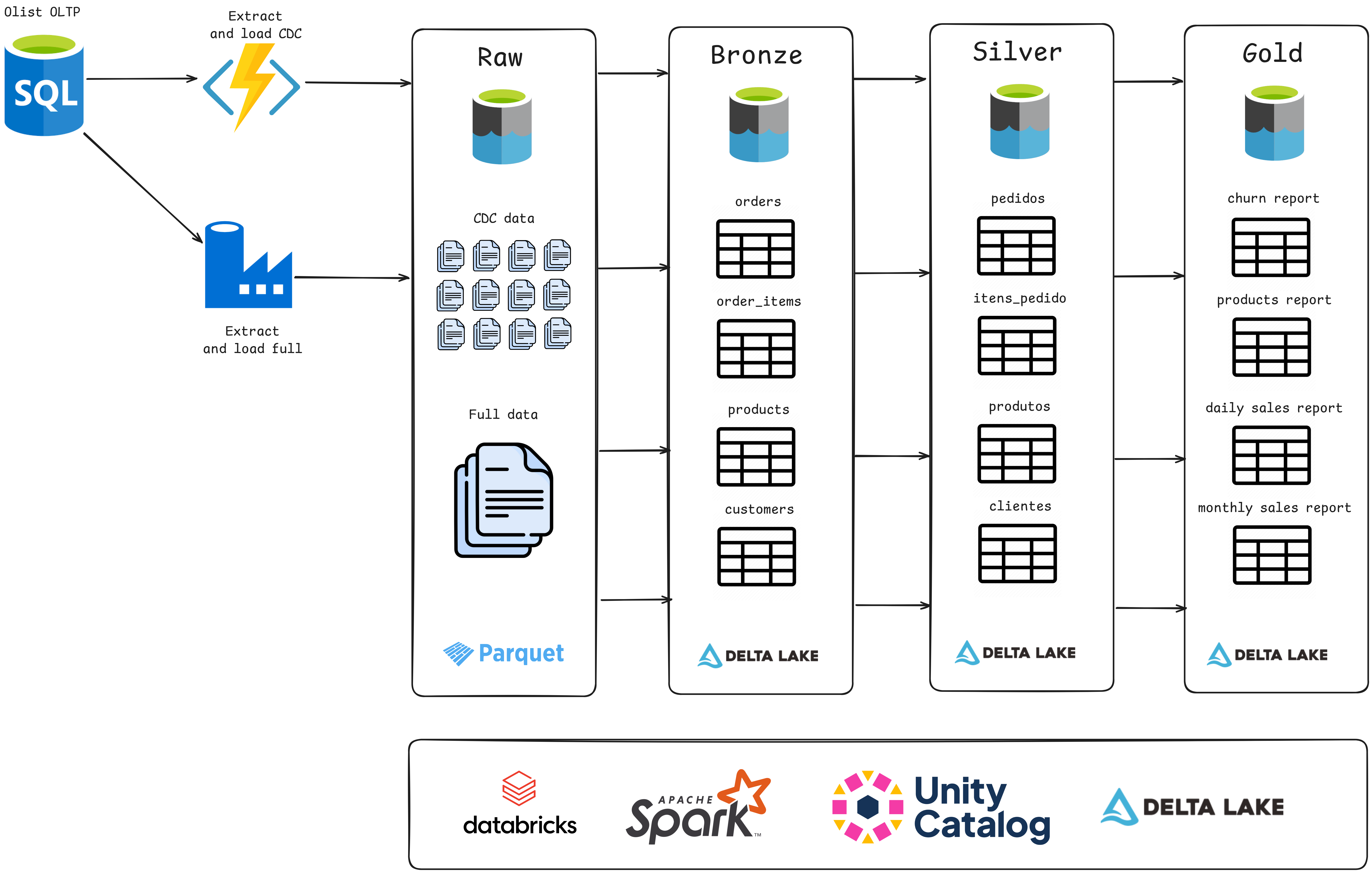

Data Lakehouse: Olist

Este projeto utilizou a arquitetura de Data Lakehouse no Databricks para gerenciar dados em camadas (Raw, Bronze, Silver e Gold) e simular cenários de ingestão com CDC (Change Data Capture). Os dados, oriundos de um dataset do Kaggle, foram enriquecidos para criar um pipeline completo, desde ingestão até análise de negócios.

Implementei governança de dados com Unity Catalog, orquestração com Databricks Workflows, e integração contínua via GitHub Actions. O projeto consolidou habilidades em pipelines de dados, automação e análise com a arquitetura Medallion, otimizando o uso de dados para insights e aplicações analíticas.

Ferramentas utilizadas

- Pandas

- Git, GitHub, GitHub Actions

- Azure Blob Storage, Parquet

- Databricks, UnityCatalog

- Spark, Delta Lake

- Databricks Workflows

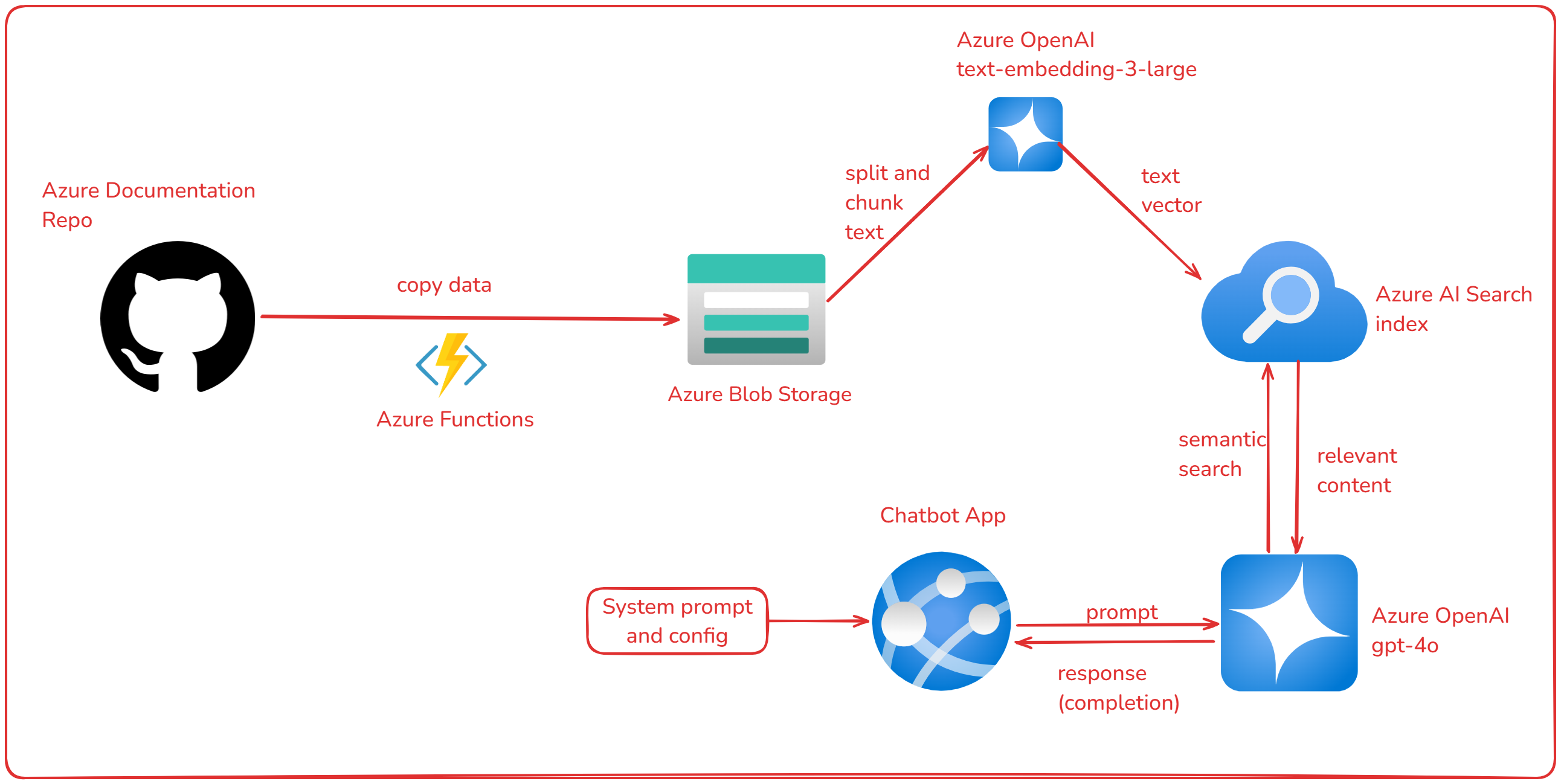

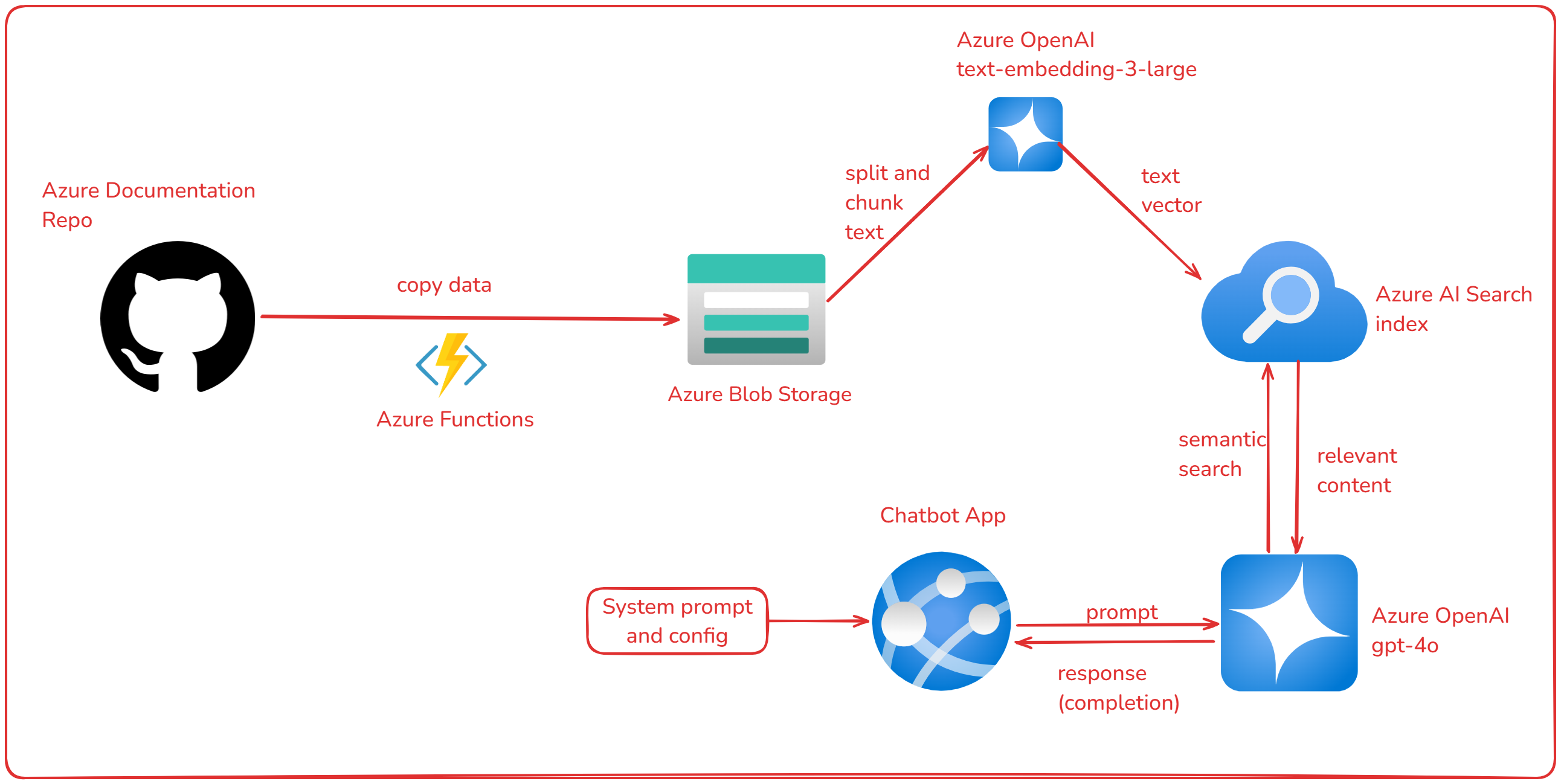

Chatbot com GPT-4 e Azure

Neste projeto, explorei ferramentas de Inteligência Artificial do Azure para construir um chatbot especializado em Azure utilizando o GPT-4. Copiei os dados da documentação do Azure no GitHub para o Storage Account, utilizei o Azure AI Search para fazer embedding e indexação do conteúdo, e o Azure OpenAI para construção do chatbot em um App no Azure. O objetivo é fornecer respostas precisas e contextualizadas sobre serviços e funcionalidades do Azure.

Ferramentas utilizadas

- Python

- Azure Blob Storage

- Azure AI Search

- Azure OpenAI

- Git, GitHub

- Bicep template (IaC)

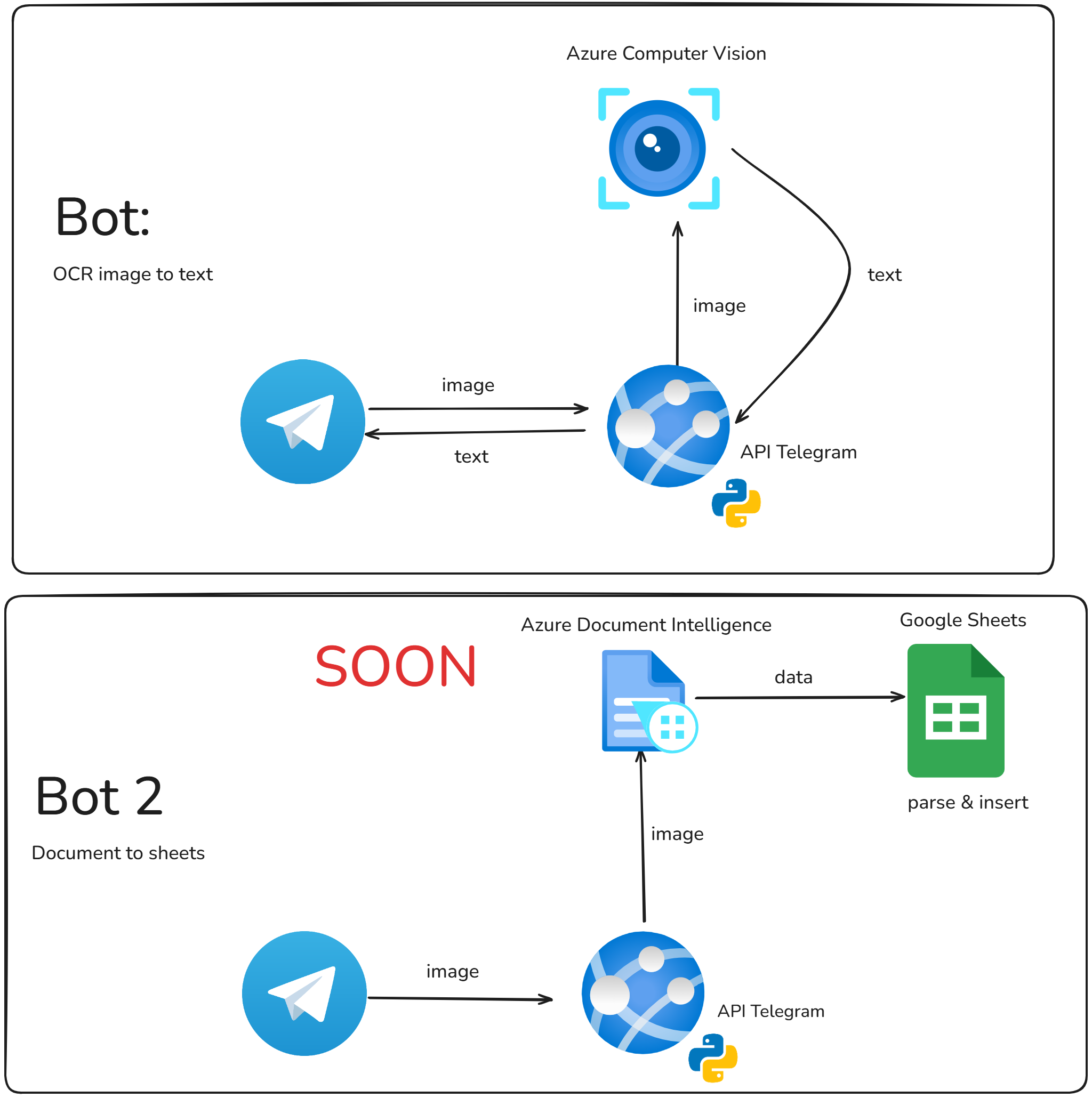

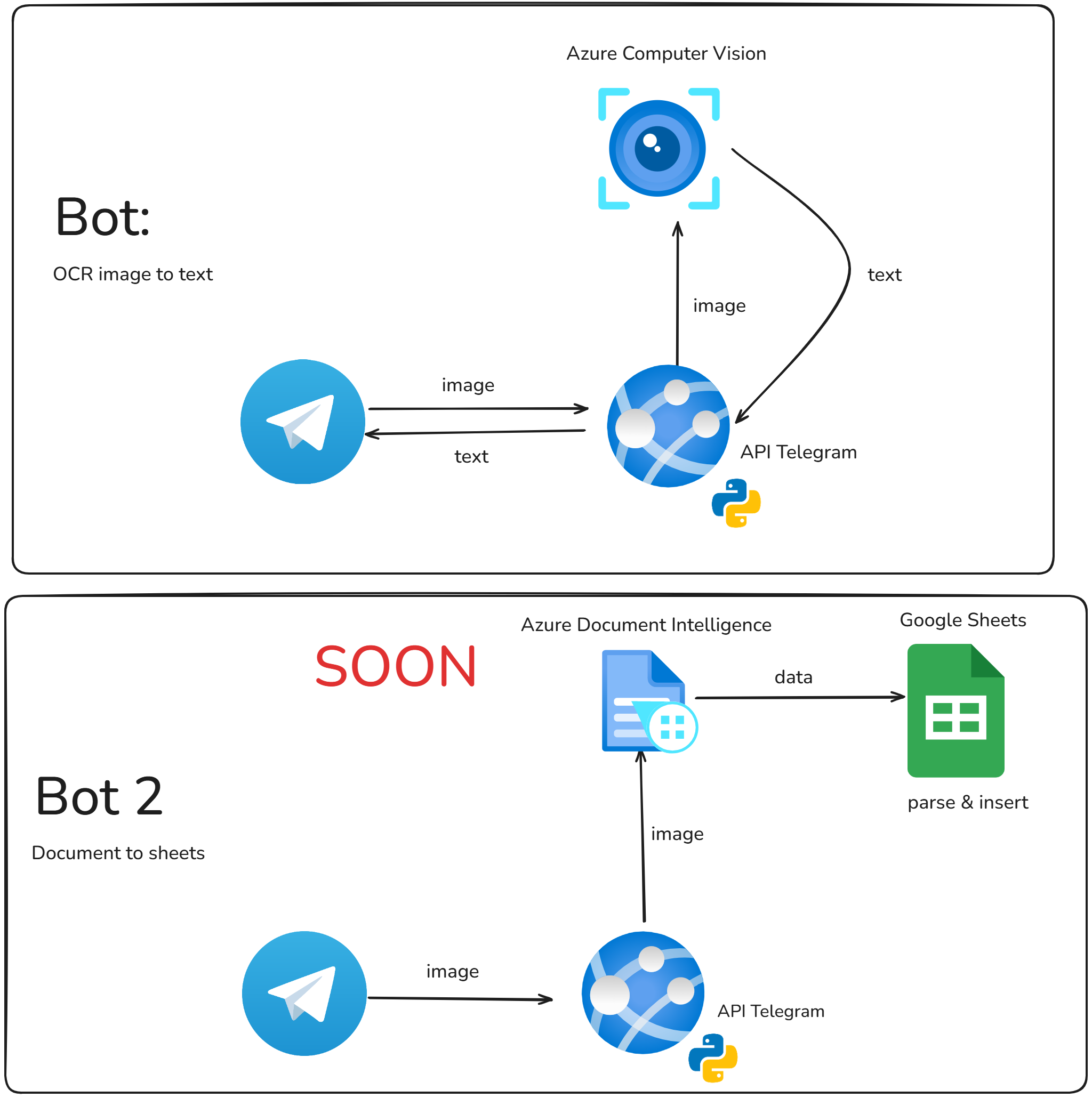

IN PROGRESS: Bot no Telegram: Reconhecimento de texto (Computer Vision)

Neste projeto, explorei ferramentas de Inteligência Artificial do Azure para reconhecimento óptico de caracteres (OCR), como o Azure Computer Vision e o Azure AI Document Intelligence. Utilizei Python para desenvolver um bot no Telegram que processa imagens enviadas pelo usuário, retornando o texto extraído e o intervalo de confiança para cada palavra reconhecida. Iimplementei configurações dinâmicas no bot, permitindo ajustar parâmetros como o nível de confiança mínima para aceitar palavras e a aplicação de pré-processamento. Esse projeto demonstra habilidades em integração com APIs, tratamento de imagens e criação de interfaces interativas com bots.

Ferramentas utilizadas

- Python

- Telegram API

- Azure Computer Vision

- Azure AI Document Intelligence

- Git, GitHub

- Bicep template (IaC)